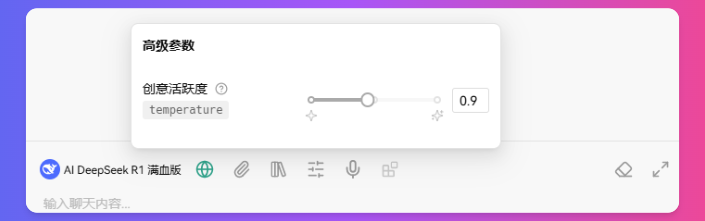

Temperature参数:控制AI模型的创造性与准确性

在大语言模型(LLM)中,Temperature参数是一个关键的超参数,它直接影响模型的输出特性。通过调整这个参数,我们可以在创造性和准确性之间找到最佳平衡点。

⚠️ 重要提示:不建议随意调整此参数,除非您充分了解其影响

Temperature参数的作用

Temperature参数控制模型输出的随机性:

- 值越高:创造性越强,输出更加多样化,但可能产生不准确或偏离主题的内容

- 值越低:输出更加确定和准确,但可能显得较为保守和重复

主流模型的Temperature参数范围

| 模型 | 取值范围 | 默认值 | 特点 |

|---|---|---|---|

| OpenAI | 0~2 | 1.0 | 通用性强,适应多种场景 |

| DeepSeek r1 | 0~1 | 0.6 | 偏向稳定性输出 |

| DeepSeek v3 | 0~2 | 1.0 | 平衡创造性与准确性 |

| Claude | 0~1 | 1.0 | 注重事实准确性 |

| Qwen | 0~2 | 0.7 | 中文场景优化 |

| Grok | 0~1 | 0.6 | 强调实用性 |

场景化参数推荐

🗣️ 对话场景

- 事实性对话:0.3-0.5

- 适用于:问答、知识咨询、技术支持

- 特点:确保回答准确、可靠

- 创意对话:0.7-0.9

- 适用于:头脑风暴、创意写作、故事创作

- 特点:激发更多创新想法

💻 编程场景

- 代码生成(质量优先):0.4

- 适用于:标准功能实现、bug修复

- 特点:生成稳定、可靠的代码

- 代码探索:0.7-0.9

- 适用于:算法优化、架构设计、创新解决方案

- 特点:探索多种可能的实现方式